[实测]DeepSeek:R1本地部署¶

1. Windows环境下的部署¶

1.1 安装Ollama¶

Ollama可以在Windows上运行DeepSeek。它可以从这里下载。

然后按照常规软件安装方式安装Ollama。【Ollama安装好后通常在后台运行,通过状态栏右键点击软件图标可以选择关闭服务。】

1.2 下载DeepSeek¶

打开

PowerShell,输入以下命令:

| 模型 | 命令 |

|---|---|

| 1.5B Qwen DeepSeek R1 | ollama run deepseek-r1:1.5b |

| 7B Qwen DeepSeek R1 | ollama run deepseek-r1:7b |

| 8B Llama DeepSeek R1 | ollama run deepseek-r1:8b |

| 14B Qwen DeepSeek R1 | ollama run deepseek-r1:14b |

| 32B Qwen DeepSeek R1 | ollama run deepseek-r1:32b |

| 70B Llama DeepSeek R1 | ollama run deepseek-r1:70b |

注:如若电脑性能欠佳,切勿选择32B或70B模型。

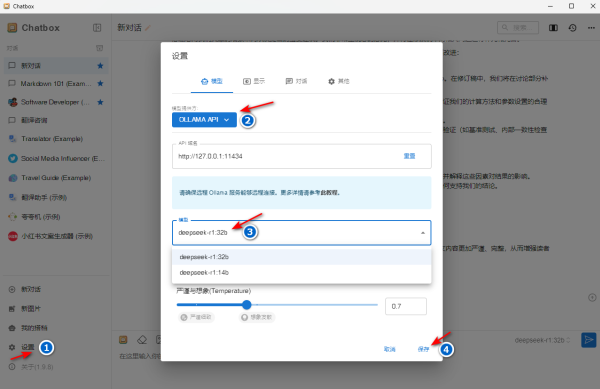

1.3 图形界面¶

安装Chatbox,可以在Windows上运行本地化DeepSeek。它可以从这里下载。

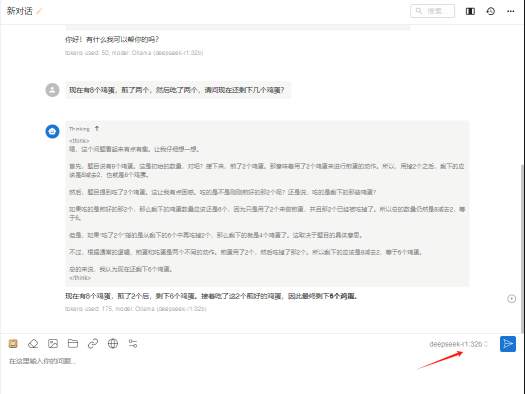

简单设置后,即可开始使用DeepSeek。(性能足够的前提下,本地部署的DeepSeek还是很智能的)

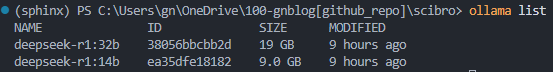

补充:查看已安装的LLM

2. Linux环境下的部署¶

2.1 安装Ollama¶

安装命令:

curl -fsSL https://ollama.com/install.sh | sh(need root permission)测试服务器中没有

GPU,会报警告。不会影响小数据测试使用。配置

ollama可以外部ip访问:vi /etc/systemd/system/ollama.service # 在Service中增加下面两行 Environment="OLLAMA_HOST=0.0.0.0" Environment="OLLAMA_ORIGINS=*" # 然后重启ollama服务 systemctl daemon-reload systemctl restart ollama

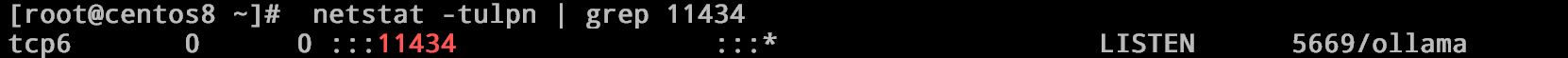

服务重启后11434端口应该是这样的:

netstat -tulpn | grep 11434

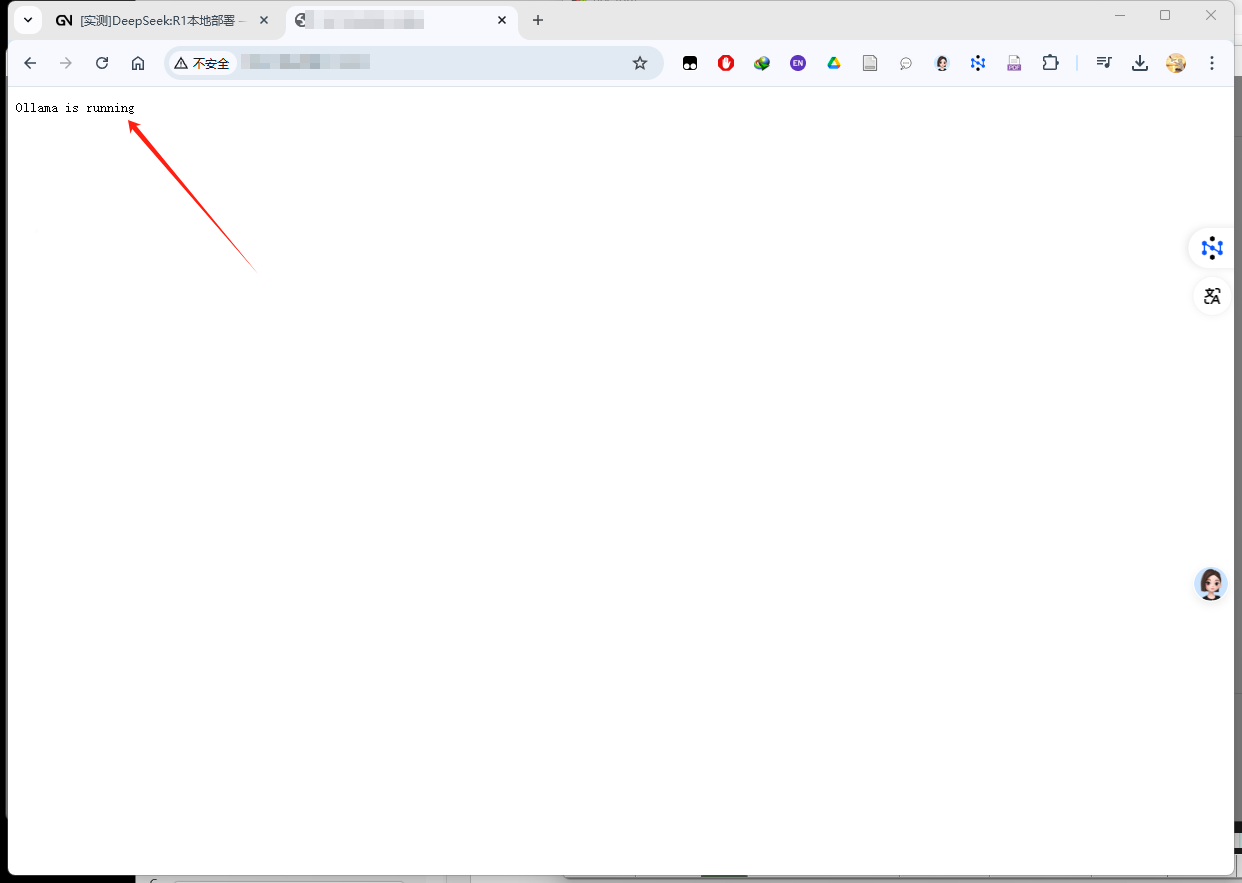

此时外部浏览器访问服务器

ip会显示Ollama is running:

然后开启服务:

sudo systemctl daemon-reload

sudo systemctl enable ollama

sudo systemctl start ollama

2.2 安装DeepSeek模型¶

下载模型:

ollama run deepseek-r1:1.5b(1.5 7 8 14 32 70)查看模型:

ollama list删除模型:

ollama delete deepseek-r1:1.5b(1.5 7 8 14 32 70)之后重启

ollama服务。

sudo systemctl restart ollama

2.3 本地访问远程服务器的DeepSeek¶

打开ChatBox,进行如下图设置即可远程访问LLM服务:

3. 常见问题¶

3.1 如何查看DeepSeek的日志?¶

在Linux环境下,可以通过以下命令查看DeepSeek的日志:

tail -f ~/.ollama/logs/deepseek-r1.log

在Windows环境下,可以在

C:\Users\用户名\.ollama\logs目录下查看日志文件。如果遇到问题,可以将日志文件发送给DeepSeek的开发者以便解决问题。

如果日志文件过大,可以使用

tail -f ~/.ollama/logs/deepseek-r1.log | grep "关键词"来查看关键信息。

注:本文档仅供学习交流使用,如有侵权,请联系删除。